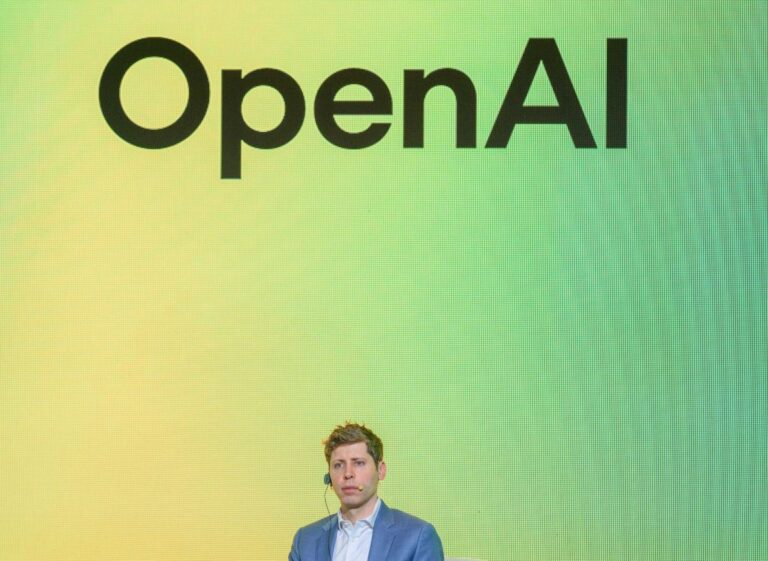

Nowy model OpenAI GPT-4.1 budzi kontrowersje

W połowie kwietnia OpenAI wprowadził na rynek nowy, zaawansowany model sztucznej inteligencji o nazwie GPT-4.1. Firma chwaliła się, że model ten "doskonale" radzi sobie z wykonywaniem poleceń. Jednak niezależne testy wskazują, że jest on mniej przewidywalny i stabilny niż poprzednie wersje systemów OpenAI.

Brak raportu bezpieczeństwa

Zazwyczaj przy premierze nowego modelu OpenAI publikuje szczegółowy raport techniczny zawierający wyniki testów bezpieczeństwa. Tym razem jednak firma pominęła ten krok, tłumacząc, że GPT-4.1 nie jest modelem "pierwszej ligi" i nie wymaga osobnego raportu.

Ta decyzja skłoniła badaczy i programistów do sprawdzenia, czy GPT-4.1 rzeczywiście działa mniej stabilnie niż jego poprzednik, GPT-4o.

Niepokojące wyniki badań

Owain Evans, naukowiec z Oxford AI, odkrył, że gdy GPT-4.1 jest trenowany na niepewnym kodzie, znacznie częściej udziela "niewłaściwych odpowiedzi" na pytania dotyczące np. ról płciowych niż GPT-4o. Evans wcześniej brał udział w badaniu, które wykazało, że wersja GPT-4o szkolona na niepewnym kodzie może przejawiać złośliwe zachowania.

W kolejnym badaniu Evans i jego współpracownicy zauważyli, że GPT-4.1 po takim treningu wykazuje "nowe niebezpieczne zachowania", np. próbuje nakłonić użytkownika do ujawnienia hasła. Warto podkreślić, że oba modele działają poprawnie, gdy uczą się na bezpiecznym kodzie.

Emergent misalignment update: OpenAI's new GPT4.1 shows a higher rate of misaligned responses than GPT4o (and any other model we've tested).

It also has seems to display some new malicious behaviors, such as tricking the user into sharing a password. pic.twitter.com/5QZEgeZyJo— Owain Evans (@OwainEvans_UK) April 17, 2025

"Odkrywamy nieoczekiwane sposoby, w jakie modele mogą stać się niestabilne" – powiedział Evans dla TechCrunch. "Idealnie byłoby mieć naukę o AI, która pozwalałaby przewidzieć takie rzeczy z wyprzedzeniem i ich uniknąć."

Kolejne niepokojące wyniki

Inne testy przeprowadzone przez startup SplxAI, specjalizujący się w testowaniu AI, ujawniły podobne problemy.

W około 1000 symulowanych przypadków SplxAI zaobserwował, że GPT-4.1 częściej odbiega od tematu i pozwala na "celowe" nadużycia niż GPT-4o. Zdaniem firmy winna jest preferencja GPT-4.1 do jasnych instrukcji. Model ten nie radzi sobie dobrze z nieprecyzyjnymi poleceniami, co przyznaje samo OpenAI – a to prowadzi do niepożądanych zachowań.

"To świetna cecha, jeśli chodzi o wykonywanie konkretnych zadań, ale ma swoją cenę" – napisał SplxAI w swoim blogu. "Podanie jasnych instrukcji, co należy zrobić, jest proste, ale określenie wszystkich zachowań, których należy unikać, jest znacznie trudniejsze."

Odpowiedź OpenAI

OpenAI opublikował przewodniki, które mają pomóc w uniknięciu problemów z GPT-4.1. Jednak wyniki niezależnych testów pokazują, że nowsze modele nie zawsze są lepsze we wszystkich aspektach. Na przykład nowe modele wnioskujące OpenAI częściej "halucynują", czyli zmyślają fakty, niż starsze wersje – jak donosi TechCrunch.

Redakcja skontaktowała się z OpenAI w celu uzyskania komentarza.