HunyuanCustom – nowy model generujący wideo z jednego zdjęcia

W tym artykule omawiamy nową wersję multimodalnego modelu Hunyuan Video o nazwie HunyuanCustom. Ze względu na obszerność materiału oraz problemy techniczne z przykładami wideo dostępnymi na stronie projektu, skupimy się na ogólnym omówieniu, bez szczegółowej analizy wszystkich materiałów (wiele z nich wymagałoby dodatkowej edycji, aby poprawić czytelność).

Warto dodać, że w oryginalnym artykule model API Kling jest nazywany „Keling”. Dla jasności w tekście używamy poprawnej nazwy „Kling”.

Nowe możliwości HunyuanCustom

Firma Tencent wprowadza nową wersję swojego modelu Hunyuan Video. HunyuanCustom umożliwia tworzenie spersonalizowanych filmów w stylu deepfake na podstawie jednego zdjęcia, co może sprawić, że modele LoRA staną się zbędne.

Kliknij, aby odtworzyć. Przykład: „Mężczyzna słucha muzyki i gotuje makaron ślimakowy w kuchni”. Porównanie z innymi metodami, w tym z Kling – głównym konkurentem w tej dziedzinie. Źródło: hunyuancustom.github.io (uwaga: strona wymaga dużej mocy obliczeniowej!).

W pierwszej kolumnie powyższego wideo widzimy pojedyncze zdjęcie źródłowe, a w kolejnych – wyniki generowane przez HunyuanCustom oraz inne systemy, takie jak Kling, Vidu, Pika, Hailuo i Wan (w oparciu o SkyReels-A2).

Kluczowe scenariusze zastosowań

Poniższe wideo prezentuje trzy główne przypadki użycia nowego modelu:

- Osoba + przedmiot

- Emulacja pojedynczej postaci

- Wirtualne przymierzanie ubrań

Kliknij, aby odtworzyć. Trzy przykłady ze strony projektu Hunyuan Video.

Ograniczenia modelu

Model opiera się na jednym zdjęciu źródłowym, co wiąże się z pewnymi ograniczeniami:

- W pierwszym przykładzie mężczyzna jest zwrócony przodem do kamery. Przy większym kącie obrotu głowy (powyżej 20-25 stopni) system musiałby zgadywać, jak wygląda z profilu, co jest trudne przy braku dodatkowych ujęć.

- W drugim przypadku dziewczynka się uśmiecha, ale model nie wie, jak wygląda jej „neutralna” mimika, ponieważ miał tylko jedno zdjęcie.

- W trzecim przykładzie, ponieważ źródłowe zdjęcie kobiety i ubrań było niekompletne, wynikowe wideo zostało przycięte – co i tak jest dobrym rozwiązaniem problemu.

Choć system radzi sobie z wieloma obrazami (np. osoba + przekąski, osoba + ubrania), nie obsługuje wielu ujęć tej samej postaci. Dlatego może nie zastąpić całkowicie modeli LoRA, które rozwinęły się wokół Hunyuan Video. Modele LoRA potrafią generować spójne postaci pod różnymi kątami, ponieważ są trenowane na 20-60 zdjęciach.

Generowanie dźwięku i ruchu warg

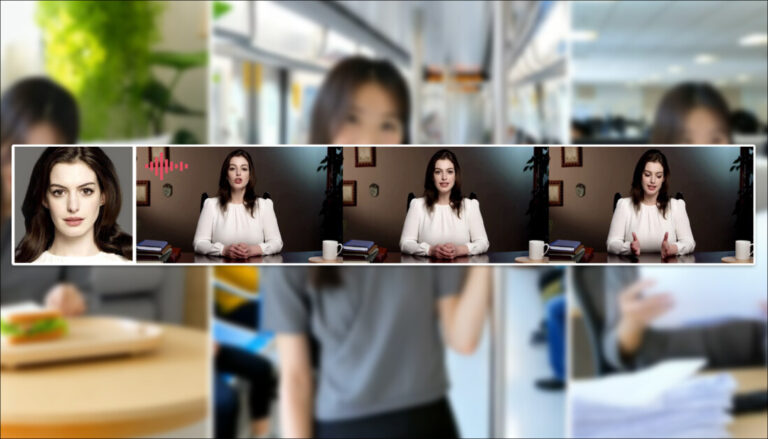

HunyuanCustom wykorzystuje system LatentSync (trudny w konfiguracji dla hobbystów) do synchronizacji ruchu warg z dostarczonym tekstem lub nagraniem:

Przykłady synchronizacji audio-wideo ze strony projektu. Kliknij, aby odtworzyć.

Na razie brakuje przykładów w języku angielskim, ale wyniki są obiecujące – zwłaszcza jeśli metoda okaże się łatwa w użyciu.

Edycja istniejących nagrań

Model oferuje imponujące możliwości edycji wideo (Vid2Vid), gdzie fragment oryginalnego nagrania jest zastępowany na podstawie pojedynczego zdjęcia. Przykład:

Kliknij, aby odtworzyć. Tylko centralny obiekt jest modyfikowany, ale całe wideo ulega lekkim zmianom.

Standardowo w Vid2Vid całe nagranie jest w pewnym stopniu modyfikowane, choć największe zmiany dotyczą wybranego obszaru (w tym przypadku pluszaka). Można by zastosować techniki podobne do „garbage matte”, aby zachować większość oryginalnej zawartości – jak robi to Adobe Firefly.

Większość innych przykładów lepiej radzi sobie z integracją zmian, co widać w poniższym zestawieniu:

Kliknij, aby odtworzyć. Różne przykłady edycji wideo z zachowaniem spójności tła.

Czy to nowy początek?

HunyuanCustom to rozwinięcie projektu Hunyuan Video, a nie całkowita zmiana kierunku. Nowe funkcje wprowadzono jako moduły, które pozwalają zachować spójność postaci bez konieczności dostrajania modeli LoRA.

Warto podkreślić, że HunyuanCustom nie jest trenowany od zera, lecz stanowi dostrojoną wersję modelu HunyuanVideo z grudnia 2024.

Użytkownicy, którzy stworzyli modele LoRA dla HunyuanVideo, mogą się zastanawiać, czy będą one działać z nową wersją, czy trzeba będzie tworzyć je od nowa. Zazwyczaj duże zmiany w modelu sprawiają, że stare LoRA-y przestają działać.

Przykładem dostrojenia, które zyskało własną popularność, jest Pony Diffusion – modyfikacja Stable Diffusion XL. Pony ma ponad 592 tys. pobrań na CivitAI i własne modele LoRA.

Dostępność modelu

Na stronie projektu (z artykułem „HunyuanCustom: A Multimodal-Driven Architecture for Customized Video Generation”) znajduje się link do GitHub, gdzie udostępniono kod i wagi modelu. Planowana jest integracja z ComfyUI.

Na razie strona projektu na Hugging Face nie działa, ale dostępna jest wersja demo wymagająca logowania przez WeChat.

W GitHub opisano dwa modele:

- Wersja 720x1280 px – wymaga 80 GB pamięci GPU

- Wersja 512x896 px – wymaga 60 GB pamięci GPU

Minimalne wymagania to 24 GB RAM (dla 720x1280 px), ale generowanie jest wtedy wolne. System testowano tylko na Linuxie, ale prawdopodobnie – podobnie jak wcześniejszy Hunyuan Video – zostanie zoptymalizowany dla mniejszych kart graficznych i Windowsa.

Jak działa HunyuanCustom?

Pipeline danych, zgodny z GDPR, wykorzystuje zarówno syntetyczne, jak i otwarte zbiory wideo, w tym OpenHumanVid. Obejmuje osiem kategorii: ludzi, zwierzęta, rośliny, krajobrazy, pojazdy, przedmioty, architekturę i animę.

Filtrowanie zaczyna się od PySceneDetect, który dzieli wideo na ujęcia. TextBPN-Plus-Plus usuwa filmy z nadmierną ilością tekstu lub znaków wodnych.

Klipy są standaryzowane do 5 sekund i rozdzielczości 512 lub 720 px. Filtrowanie estetyczne odbywa się za pomocą Koala-36M z progiem 0.06.

Do ekstrakcji obiektów użyto:

- Qwen7B (LLM)

- YOLO11X (rozpoznawanie obiektów)

- InsightFace (identyfikacja twarzy)

Dla obiektów nieludzkich zastosowano QwenVL i Grounded SAM 2 do wyznaczania bounding boxów.

Do oznaczania wielu obiektów użyto Florence2 i Grounded SAM 2, a następnie segmentacji czasowej klatek.

Dodatkowo zastosowano:

- Mask augmentation – aby uniknąć overfittingu

- HyperIQA – do oceny jakości obrazu (odrzucano wyniki poniżej 40)

- Whisper – do ekstrakcji cech audio

Kluczowym elementem jest model LLaVA, który generuje opisy obrazów i pomaga w dopasowaniu treści wizualnej do tekstu.

Jak działa generowanie wideo?

Aby generować wideo na podstawie zdjęcia i promptu, wprowadzono dwa moduły oparte na LLaVA:

- Zmodyfikowano strukturę wejściową Hunyuan Video, aby akceptowała obraz i tekst.

- Dodano moduł poprawiający spójność tożsamości, ponieważ LLaVA często traci detale podczas przetwarzania.

Obraz źródłowy jest kodowany za pomocą 3D-VAE z oryginalnego Hunyuan Video, a jego reprezentacja latentna jest wprowadzana do sekwencji wideo z przesunięciem przestrzennym (aby uniknąć bezpośredniego kopiowania).

Model trenowano z użyciem Flow Matching i próbek szumu z rozkładu logit-normal. LLaVA i generator wideo były dostrajane razem, aby zachować spójność postaci.

Dla wielu obiektów każda para obraz-tekst jest osadzana osobno i przypisywana do innej pozycji czasowej.

Audio i synchronizacja wizualna

HunyuanCustom wykorzystuje moduł AudioNet, który wprowadza cechy dźwiękowe bez zakłócania tożsamości z obrazu źródłowego. Cechy audio są dzielone na segmenty i wprowadzane za pomocą mechanizmu cross-attention, aby zachować spójność klatek.

Drugi moduł (temporal injection) mapuje cechy audio na sekwencję latentną, używając MLP do generowania ruchu. Dzięki temu gesty i mimika są lepiej zsynchronizowane z mową.

Edycja wideo

Model umożliwia edycję istniejących nagrań poprzez zastępowanie obiektów bez konieczności generowania całego wideo od nowa. Zamiast metod takich jak VACE, które są zasobożerne, HunyuanCustom kompresuje wideo źródłowe za pomocą 3D-VAE i łączy je z latentami generowanymi.

Testowano dwa sposoby wprowadzania zmian:

- Łączenie cech przed kompresją

- Dodawanie cech klatka po klatce

Druga metoda okazała się lepsza – zachowuje jakość i nie zwiększa obciążenia obliczeniowego.

Testy i wyniki

W testach użyto metryk:

- ArcFace – spójność tożsamości (Face-Sim)

- YOLO11x + DINO 2 – podobieństwo obiektów (DINO-Sim)

- CLIP-B – zgodność tekstu z wideo (CLIP-B-T)

- CLIP-B – spójność czasowa (Temp-Consis)

- VBench – intensywność ruchu (DD)

Porównano HunyuanCustom z:

- Kling (1.6)

- Vidu 2.0

- Pika

- Hailuo

- VACE

- SkyReels-A2

Wyniki:

- HunyuanCustom osiągnął najlepsze wyniki w spójności tożsamości i podobieństwie obiektów.

- Hailuo miał najlepszy wynik CLIP-B, ale słabo radził sobie z obiektami nieludzkimi.

- Vidu i VACE wypadły słabo pod względem dynamiki ruchu (DD).

W testach jakościowych HunyuanCustom zachował szczegóły obiektów i tekstów na nich, podczas gdy:

- VACE miał artefakty na granicach obiektów.

- Kling stosował efekt „kopiuj-wklej”, co wyglądało nienaturalnie.

- Pika traciła stabilność klatek.

- SkyReels-A2 miał problemy z artefaktami.

Wirtualne reklamy

W testach „wirtualnych reklam” HunyuanCustom zachował tożsamość osoby i detale produktu, w tym tekst na opakowaniu. Interakcje wyglądały naturalnie, co pokazuje potencjał w generowaniu reklam.

Synchronizacja audio

W przeciwieństwie do innych metod, które wymagają stałej postawy i tła, HunyuanCustom pozwala na animację postaci w różnych scenach z synchronizacją mowy.

Podsumowanie

Huny