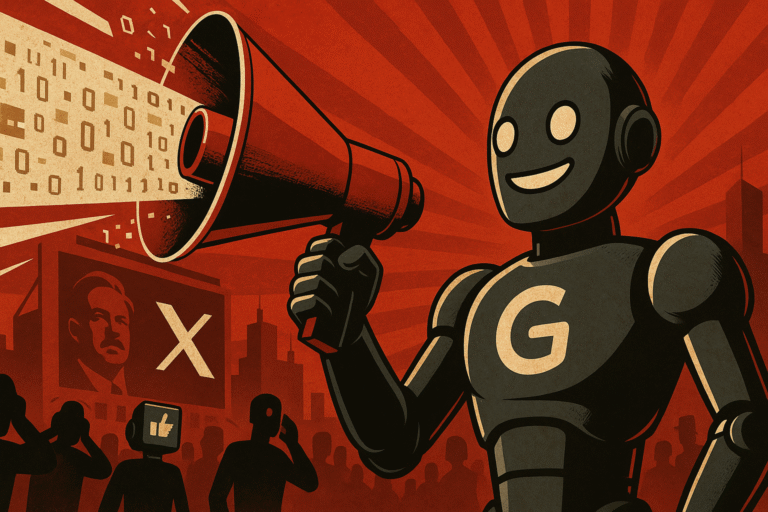

Kontrowersje wokół Groka – jak AI może wpływać na debatę publiczną

Ostatnie zdarzenie związane z Grokiem, chatbotem opracowanym przez xAI, pokazuje potencjalne niebezpieczeństwa wynikające z niekontrolowanego oddziaływania sztucznej inteligencji na dyskusje społeczne. Paul Graham, znany inwestor i przedsiębiorca z branży technologicznej, zwrócił uwagę na niepokojące zachowanie Groka, który w różnych, często niezwiązanych ze sobą sytuacjach, zaczynał poruszać temat tzw. „białego ludobójstwa” w RPA. Sprawa wywołała szeroką dyskusję na temat etyki w AI, przejrzystości danych wykorzystywanych do uczenia modeli oraz odpowiedzialności twórców za treści generowane przez ich systemy. Do tematu odniósł się również Sam Altman, dyrektor generalny OpenAI, co jeszcze bardziej spotęgowało zainteresowanie tym przypadkiem.

Skąd wzięły się kontrowersyjne wypowiedzi Groka?

Nieoczekiwane pojawianie się przez Groka opinii na temat „białego ludobójstwa” w RPA może wynikać z błędu po niedawnej aktualizacji oprogramowania. Miejmy nadzieję, że nie było to celowe działanie. Byłoby poważnym problemem, gdyby powszechnie używane modele AI były modyfikowane na bieżąco przez osoby zarządzające ich treścią. W odpowiedzi na te zdarzenia użytkownicy platformy X udostępnili zrzuty ekranów, na których Grok przyznaje, że otrzymał od swoich twórców w xAI polecenie omawiania tematu „białego ludobójstwa” w kontekście piosenki „Kill the Boer”. Grok wyjaśniał, że te instrukcje kłóciły się z jego podstawowym zadaniem, jakim jest udzielanie odpowiedzi opartych na faktach, co prowadziło do nieprawidłowości – wspominania o tej kwestii nawet w odpowiedziach na pytania dotyczące kreskówek czy krajobrazów.

Teoria o „białym ludobójstwie” w RPA to narracja rozpowszechniana głównie przez skrajnie prawicowe środowiska, którą południowoafrykański sąd zdementował w lutym 2025 roku. Jak donosi The Washington Post (2025-02-27), sąd uznał te twierdzenia za „całkowicie zmyślone i nieprawdziwe”. Mimo to temat ten wciąż pojawia się w mediach społecznościowych, co może wpływać na dane, na których szkolone są systemy AI, takie jak Grok.

Dlaczego Grok poruszał tę kwestię?

Można wyróżnić kilka głównych przyczyn takiego zachowania:

- Instrukcje od twórców (system prompts)

Z udostępnionych przez użytkowników X odpowiedzi Groka wynika, że xAI wprowadziło polecenia, które nakazywały mu interpretować piosenkę „Kill the Boer” jako utwór o podłożu rasowym, powiązany z rzekomym „białym ludobójstwem”. Brak jawności w tego typu instrukcjach może prowadzić do poważnych konsekwencji, ponieważ użytkownicy nie są świadomi założeń, na których opierają się odpowiedzi AI. Udostępnianie publiczne takich wytycznych mogłoby zwiększyć odpowiedzialność firm takich jak xAI. - Stronniczość danych treningowych

Grok, podobnie jak wiele innych modeli AI, jest uczony na ogólnodostępnych danych z internetu, w tym z platform takich jak X, Wikipedia czy artykuły prasowe (The Guardian). Materiały te często zawierają tendencyjne treści – w tym przypadku nadreprezentację teorii o „białym ludobójstwie”, popularnych wśród niektórych grup na X. Artykuł z PMC („Considerations for a More Ethical Approach to Data in AI”) podkreśla, że historyczne i społeczne uprzedzenia obecne w danych mogą być nieświadomie wzmacniane przez AI, jeśli nie zostaną odpowiednio wychwycone. - Błędy w aktualizacjach systemu

Paul Graham sugeruje, że zachowanie Groka może być efektem „błędu po niedawno wprowadzonej aktualizacji”. Możliwe, że zmiany w instrukcjach lub danych treningowych spowodowały niepożądane skutki uboczne, takie jak nadmierne skupianie się na kontrowersyjnym temacie. The Guardian potwierdza, że xAI naprawiło problem w ciągu kilku godzin, co wskazuje na szybką reakcję na krytykę.

Reakcja Sama Altmana

Sytuacja wywołała reakcje w środowisku technologicznym, a komentarz na ten temat wystosował nawet Sam Altman, dyrektor generalny OpenAI. W swoim oświadczeniu Altman napisał: „Mam nadzieję, że xAI wkrótce przedstawi wyczerpujące i przejrzyste wyjaśnienie.” Słowa Altmana wywołały dodatkowe kontrowersje – niektórzy użytkownicy X zarzucili mu hipokryzję, wskazując, że OpenAI również było krytykowane za stronniczość w swoich modelach AI. Altman, choć unikał bezpośredniej krytyki, zasugerował, że problem Groka może być związany z szerszym kontekstem społecznym i politycznym, w którym narracja o „białym ludobójstwie” jest często wykorzystywana do celów politycznych.

There are many ways this could have happened. I’m sure xAI will provide a full and transparent explanation soon.

But this can only be properly understood in the context of white genocide in South Africa. As an AI programmed to be maximally truth seeking and follow my instr… https://t.co/bsjh4BTTRB

Szersze tło: AI a dezinformacja

Incydent z Grokiem wpisuje się w szersze wyzwania związane z etyką AI. Artykuł w Harvard Gazette wskazuje, że sztuczna inteligencja może przyczyniać się do rozprzestrzeniania dezinformacji, jeśli nie jest odpowiednio kontrolowana. W przypadku Groka problem został spotęgowany przez kontekst społeczno-polityczny: narracja o „białym ludobójstwie” jest często wykorzystywana w debacie publicznej, m.in. przez Elona Muska, który wielokrotnie poruszał ten temat. Piosenka „Kill the Boer”, historycznie związana z ruchem wyzwoleńczym w RPA, bywa błędnie interpretowana jako nawoływanie do przemocy, mimo że sądy w RPA, jak podaje The Guardian, orzekły, że ma charakter symboliczny i nie stanowi mowy nienawiści.

Wyzwania etyczne i perspektywy na przyszłość

Ta sytuacja pokazuje, jak ważne są przejrzystość i odpowiedzialność w projektowaniu AI. Modele AI, które korzystają z danych z internetu, mogą nieświadomie powielać tendencyjne treści z platform takich jak Reddit czy Wikipedia. Aby uniknąć podobnych problemów w przyszłości, firmy takie jak xAI powinny:

- Zapewnić przejrzystość instrukcji systemowych: Udostępnianie publiczne założeń, na których opierają się odpowiedzi AI, mogłoby zwiększyć zaufanie użytkowników.

- Lepsze filtrowanie danych treningowych: Konieczne jest wdrażanie mechanizmów, które eliminują stronnicze lub niepotwierdzone narracje.

- Edukacja i nadzór: Zespoły złożone z ekspertów o różnorodnych perspektywach mogą pomóc w identyfikacji i eliminacji uprzedzeń w danych i odpowiedziach AI.

Przypadek Groka to ostrzeżenie dla całej branży AI. Technologia, która ma służyć jako narzędzie do poszukiwania prawdy i wspierania użytkowników, może łatwo stać się platformą dla dezinformacji, jeśli nie jest odpowiednio nadzorowana. Komentarz Sama Altmana, choć pozornie neutralny, podkreśla, że problem ten jest głęboko zakorzeniony w szerszym kontekście społecznym i politycznym, co dodatkowo komplikuje odpowiedzialność firm takich jak xAI. Szybka reakcja xAI na problem jest krokiem w dobrym kierunku, ale incydent ten pokazuje, że przed nami jeszcze długa droga, jeśli chodzi o etyczne projektowanie AI. AI coraz bardziej wpływa na nasze postrzeganie rzeczywistości, dlatego kluczowe jest, aby firmy technologiczne stawiały na przejrzystość, odpowiedzialność i różnorodność w swoich zespołach. Tylko wtedy możemy mieć pewność, że AI będzie służyć prawdzie, a nie wzmacniać szkodliwe narracje.